Un nuevo estudio de Apple propone avances en el procesamiento de fotografías con poca luz – MacMagazine

Un nuevo estudio [PDF] de investigadores de Manzana y de Universidad Purdue presentó el modelo DarkDiffdiseñado para mejorar la calidad de las fotografías capturadas en condiciones de iluminación extremadamente baja, que a menudo introducen ruido y otros problemas.

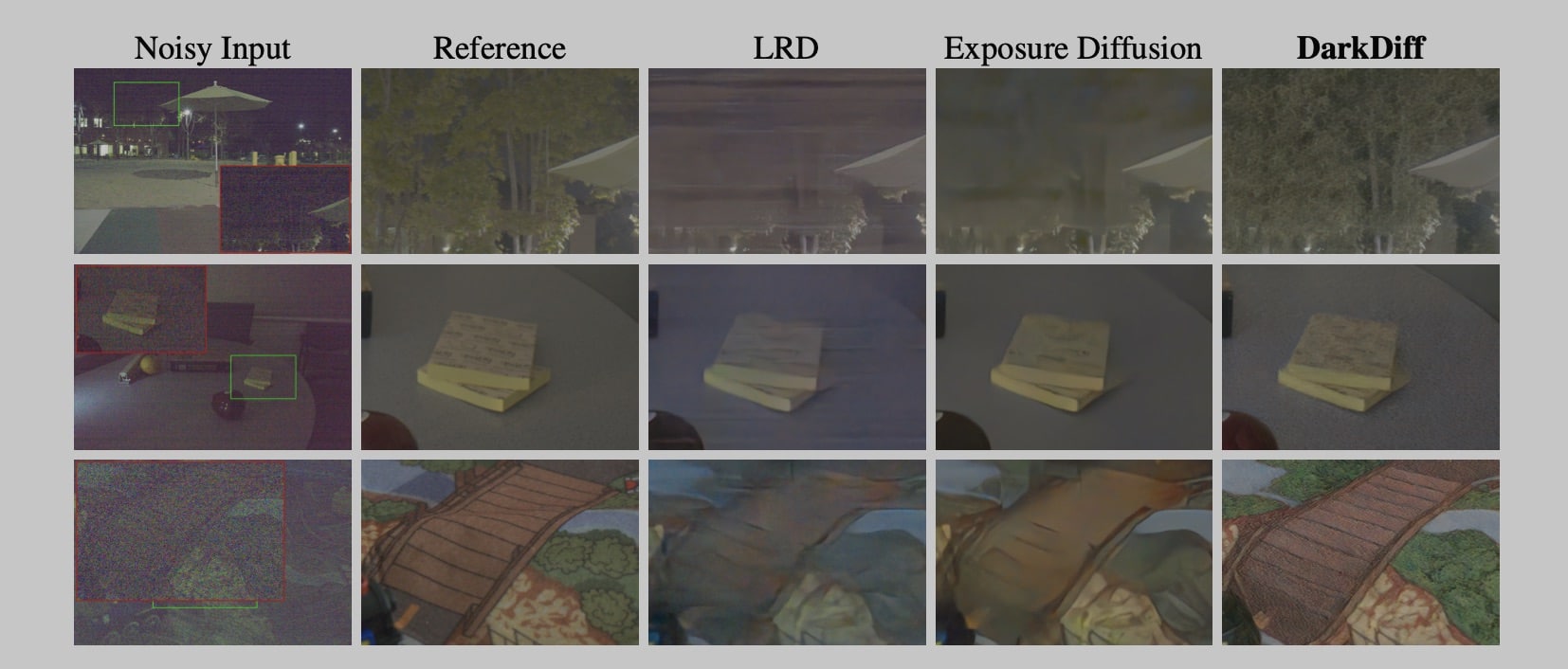

DarkDiff busca resolver dos grandes síntomas provocados por modelos actuales con el mismo fin: el excesivo suavizado (que en ocasiones deja las imágenes con aspecto de “pintura al óleo”) y la generación de elementos inexistentes (la famosa “alucinación”).

Para superar estas deficiencias, DarkDiff adapta modelos de difusión previamente entrenados (como Stable Diffusion) para trabajar con datos derivados de imágenes de cámara sin procesar (CRUDO), haciéndolo a través de cuatro pasos principales.

El primero de ellos es un tubería formato de datos personalizado, en el que los datos sin procesar se convierten a un formato llamado Linear RGB (LRGB), que acerca la imagen al tipo de datos que el modelo ya conoce, facilitando el procesamiento.

Luego, el modelo implementa la técnica. Atención cruzada basada en regionesen el que el modelo se centra en pequeños bloques locales de la imagen (y no todos a la vez, lo que provoca alucinaciones) para que los detalles generados sean más precisos.

A continuación, el modelo utiliza un codificador con conexiones residuales para ayudar a preservar la identidad del contenido y, finalmente, se aplica una función que penaliza al modelo si hay desviaciones cromáticas, evitando cambios de color.

Como resultado, DarkDiff acaba produciendo imágenes con detalles más nítidos y colores mucho más precisos en comparación con los métodos habituales en el mercado, algo que se evidencia en una serie de pruebas e imágenes presentadas en el estudio.

vía 9to5Mac